2025年4月29日にリリースされたQwen3をMac M1で試してみました。こちらはAlibaba(アリババ)社が開発した大規模言語モデル(LLM)の最新版です。「Qwen」は「通義千問(Qianwen)」の略で、「多くの問いに通じる」ことを意味します。では、早速llama.cpp(*1)を使って環境を構築してみます。

*1: llama.cpp は、Meta(旧Facebook)が公開した大規模言語モデル「LLaMA(ラマ)」シリーズを、CPU上でも高速に動かせるようにC++で実装された軽量なライブラリ/ツールです。

llama.cppのダウンロード

GitHub からダウンロードし、llama.cppに移動します。

git clone https://github.com/ggerganov/llama.cpp.git

cd llama.cppモデルの設置

例としてQwen3-4B-Q4_K_M.ggufをHugging Faceからダウンロードし、llama.cpp/modelsに保存します。

ビルド

llama.cppをMac用にビルドします。

cmake -B build cmake --build build --config Release[100%] Built target llama-q8dotと出力されたら完了です。

使ってみる

llama.cppサーバを起動します。

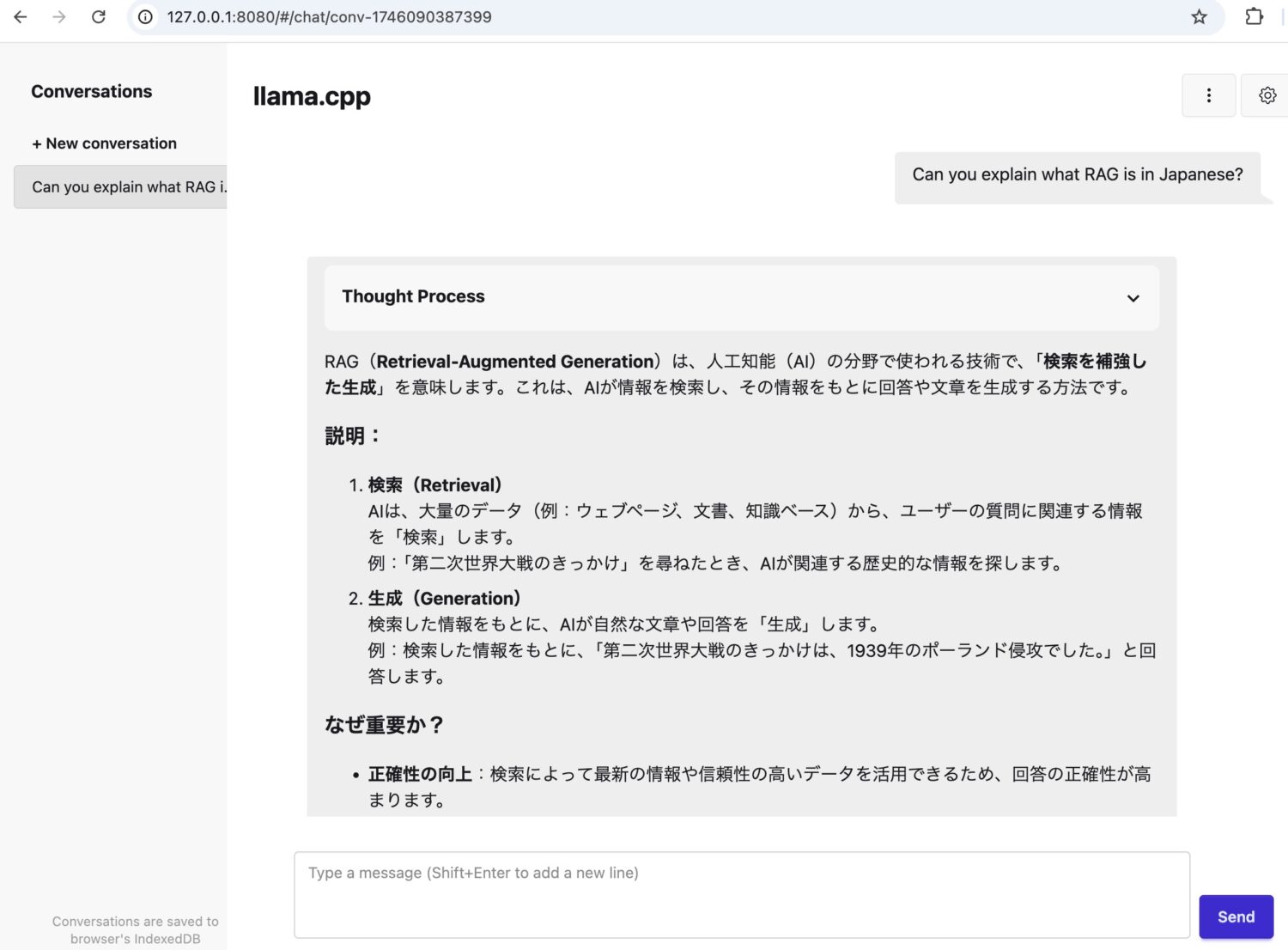

./build/bin/llama-server -m models/Qwen3-4B-Q4_K_M.gguf --port 8080http://127.0.0.1:8080にアクセスして、質問してみます。

コメント