ここでは、Mac M1チップを搭載した端末でLM Studioを使ってローカル環境で大規模言語モデル(LLM)を動かす手順を解説します。

LM Studioとは?

LM Studioは、ローカル環境で様々なオープンソースLLM(例:Llama 2、Mistralなど)を簡単にダウンロードして実行できるデスクトップアプリケーションです。インターネット接続なしでもAIチャットやドキュメント検索などが可能になります。

事前準備

- Mac M1、M2、M3、M4チップ搭載機(macOS 13.6以降)

- 16GB以上のメモリ推奨

- インターネット接続(初回ダウンロード時のみ)

インストール手順

- LM Studio公式サイトにアクセスします。

- 「Download for macOS」をクリックして、インストーラー(.dmgファイル)をダウンロードします。

- ダウンロードした.dmgファイルを開き、LM Studioアプリケーションを「Applications」フォルダにドラッグ&ドロップします。

- インストール後、LaunchpadまたはFinderからLM Studioを起動します。

初回起動と設定

- 初回起動時は、セキュリティ警告が表示される場合があります。「開く」を選択してください。

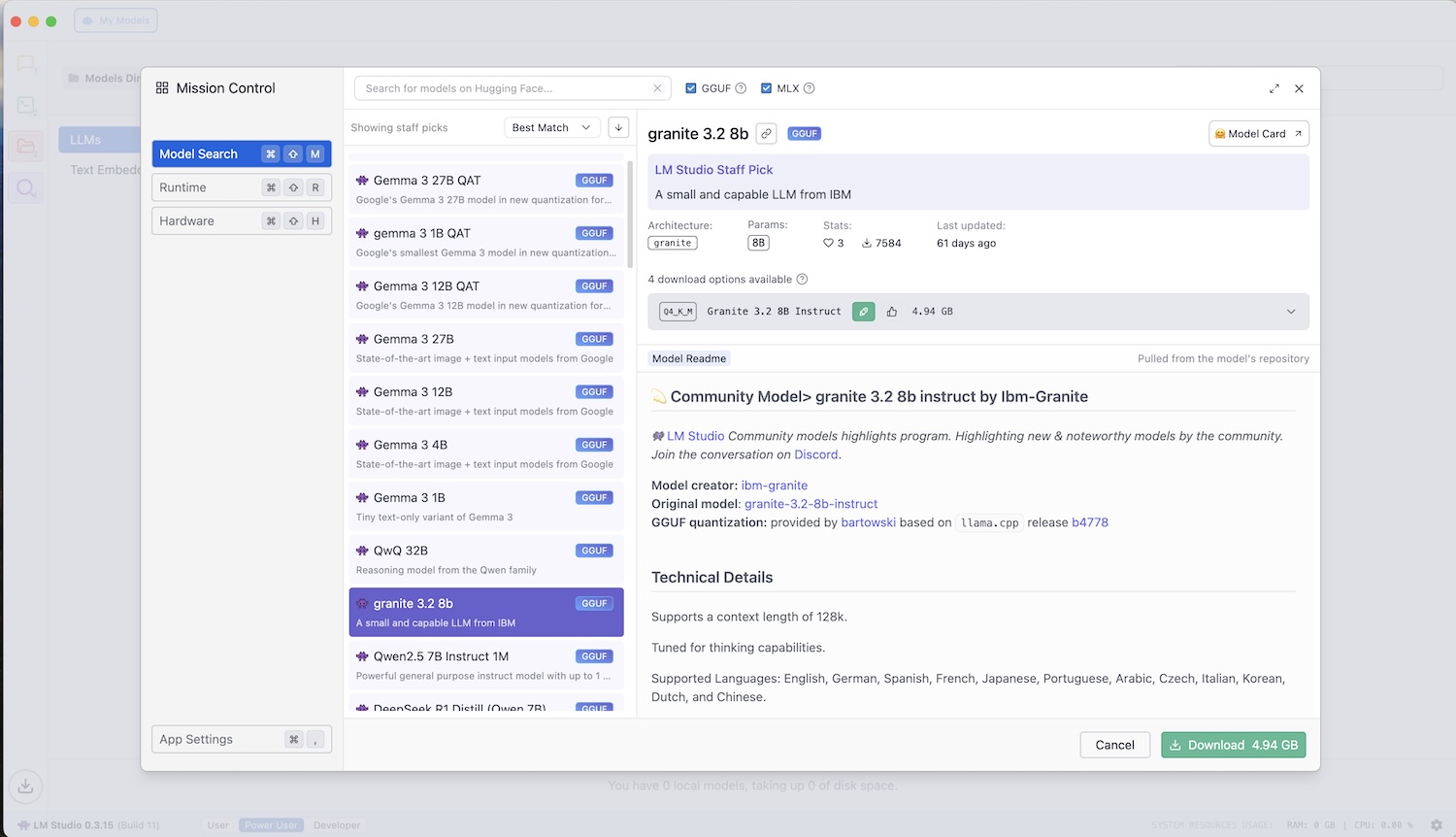

- LM Studioが起動したら、画面上部メニューから「Model Catalog」を選択します。

- 使用したいモデル(例:Llama 2、Mistralなど)を選び、「Download」をクリックします。

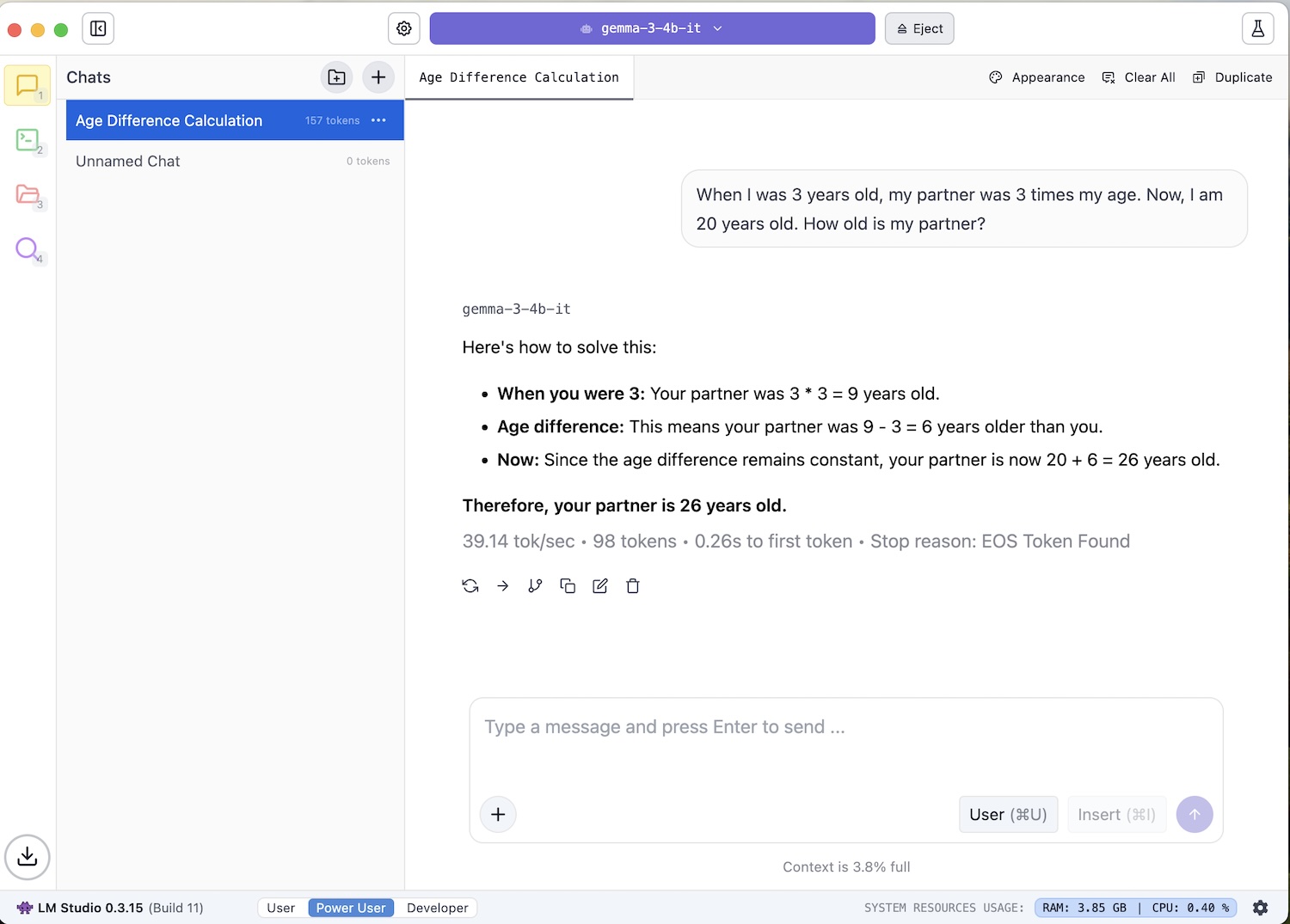

- ここでは、Googleが開発したGemmaを使ってみます。

- ダウンロード完了後、「Chat」タブで選択したモデルを使ったチャットが可能になります。

便利な機能

- ローカルAPIサーバー機能:OpenAI互換のAPIをローカルで提供できます。

- ドキュメントQ&A機能:自分のファイルをインポートし、モデルに質問できます(RAG)。

- SDK提供:PythonやTypeScriptでアプリ開発可能。

注意点

モデルサイズが大きい場合、より多くのRAMを消費します。メモリ不足が発生した場合は、より小さなモデル(例:7Bモデル)を選択すると良いでしょう。

まとめ

LM Studioを使えば、Mac M1上で簡単に高性能なLLMを動かし、プライバシーを守りながらAIを活用できます。

補足:

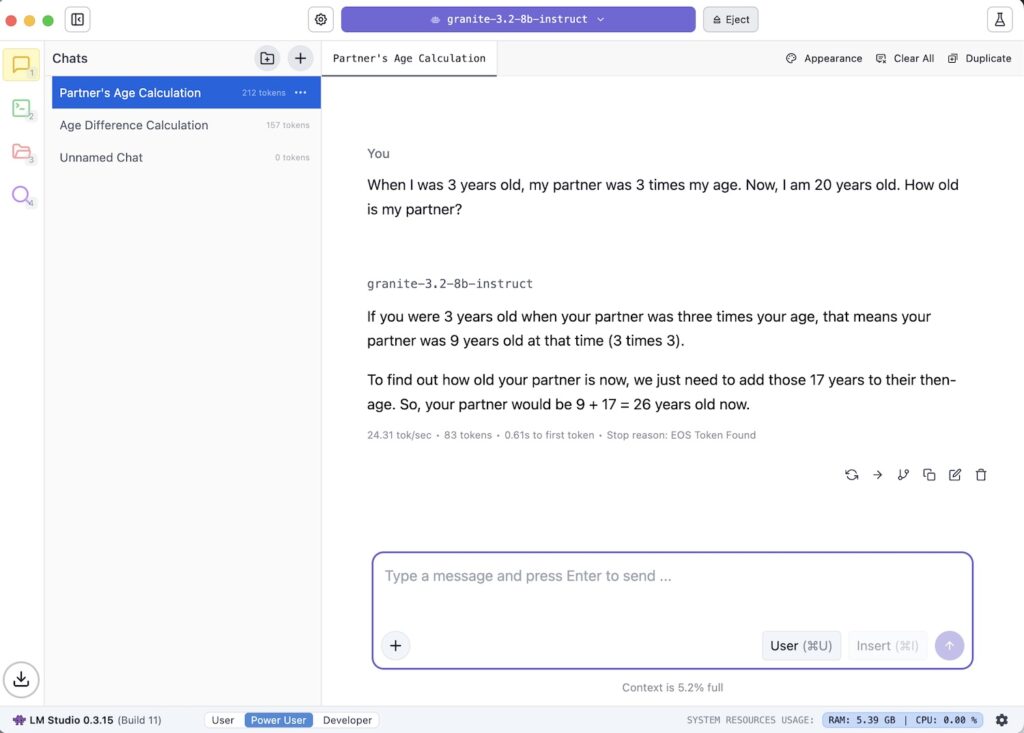

別のモデルをダウンロードして同じ質問をしてみると簡単に比較することができます。例えば、IBMのGraniteモデルを使って同じ質問をしてみた結果がこちらになります。

コメント